リアルタイムの声道のMR画像と発話しているテキスト情報

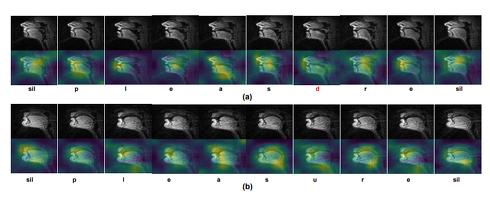

米カリフォルニア・マーセッド大学の研究チームが開発した「Silent Speech and Emotion Recognition from Vocal Tract Shape Dynamics in Real-Time MRI」は、口パク(無声発話)によって動く声道をリアルタイム磁気共鳴画像法(rtMRI)で取得し、その動きから音響情報を理解してテキストに変換する深層学習フレームワークだ。 【画像】(上)声道のMR画像、(下)声道の境界を表示したもの 声道とは、声帯が作った音を体外に出すまでに通る空洞領域を指す。今回の研究は、この声道をrtMRIを使って観察し、取得したその動きから連続音声を認識できるかを検証。連続音声認識のために、特定の声道構成に対応する音響情報を自動的に推定できる深層学習によるエンド・ツー・エンドの認識モデル(調音-音響マッピング)を構築した。 感情が音声生成時の調音運動に影響を与えるかどうか、またどのように影響を与えるかを理解するため、声道の各サブ領域(咽頭部や口蓋部、背面部、硬口蓋部、口唇狭窄部)における調音形状の変化を異なる感情と性別に応じて解析を行った。 この研究の認識モデルは、2つのサブモジュールで構成する。rtMRIで撮影したビデオフレームのシーケンスを受け取り、フレームごとに特徴ベクトルを出力する特徴抽出フロントエンドモジュールと、フレームごとの特徴ベクトルのシーケンスを入力し一文字ずつの文を予測し出力するシーケンスモデリングモジュールだ。 データセットには、話者10人の動画4000本以上を使用。声道形成のMR画像と、それに同期した音声記録、時間的に一致した単語レベルのトランスクリプションが含まれる。 提案モデルの性能を測定するために、自動音声認識(ASR)モデルの性能に関する標準的な評価指標である音素誤り率(PER)、文字誤り率(CER)、単語誤り率(WER)を計算し検証した。 その結果、PERを平均40.6%に抑えながら、声道形成のシーケンスを文章全体に自動的にマッピングできることを実証した。さらに感情(中性や幸せ、怒り、悲しみ)を関連付ける解析をしたところ、中性以外の感情の際には全ての感情において、声道の下部境界のサブ領域が上部境界のサブ領域よりも顕著に変化する傾向があると分かった。 各サブ領域の変化は、性別による変動の影響も受けており、女性の話者はポジティブな感情よりもネガティブな感情の方が咽頭領域と口蓋裂・背裂領域のゆがみが大きくなるなどを示した。 この結果は、この認識モデルが日常的に使われているさまざまなコンピュータとの入力媒体として利用できる可能性や、これによって言語障がい者や音声障がい者、視覚障がい者がコンピュータとやりとりする際にも一助になる可能性を示唆した。Source and Image Credits: Laxmi Pandey and Ahmed Sabbir Arif, “Silent Speech and Emotion Recognition from Vocal Tract Shape Dynamics in Real-Time MRI”, SIGGRAPH '21: ACM SIGGRAPH 2021 Posters, August 2021, Article No.: 27, Pages 1-2, https://doi.org/10.1145/3450618.3469176 ※テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

ITmedia NEWS